Gerador Automático de Robots.txt do Google

Assim como o Google Analytics que é usado para obter as estatísticas de visitação dos sites o Google também disponibiliza uma ferramenta de SEO gratuita bem interessante chamada Google Webmaster Tools. Para poder usar o Google Webmaster Tools, assim como no Google Analytics, basta ter uma conta no Google. Dentre as muitas funções do Webmaster Tools, uma das mais interessante com certeza é o gerador de robots.txt, que é fundamental para Otimização de Sites.

Acessando a Ferramenta de Geração do Robots.txt

Para acessar a tool de geração do Robots.txt do Google Webmaster tools basta acessar o menu principal, sessão Tools -> Generate robots.txt. Uma vez que esta opção for selecionada vai então ser iniciada a tela principal da ferramenta. Na tela principal temos 3 sessões:

- 1: Choose your default robot access: nesta sessão você escolhe qual vai ser a base do seu arquivo robots.txt, se você prefere que ele começe com o site inteiro bloqueado e você vai liberando as pastas (opção Block all robots ), ou o oposto, ele começa com o site inteiro livre e você bloqueia as pastas que forem convenientes ( opção Allow all robots ). A opção default ( e recomendada ) por ser mais comum e se aplicar a mais situações é a opção do site começar desbloqueado.

- 2: Specify any additional rules: Sessão da ferramenta que vai te ajudar a escrever as regras do robots.txt. Você pode usar essa sessão tanto para criar regras de bloqueio, quanto de desbloqueio. O crawler também pode ser escolhido aqui.

- 3: Save your robots.txt file: Nesta sessão vão sendo escritas as regras que você vai produzindo na sessão 2. Para salvar o seu robots.txt, você tem 2 opções: fazer o download dele ou então copiar e colar mesmo.

Gerando Regras para o seu Robots.txt ( passo a passo )

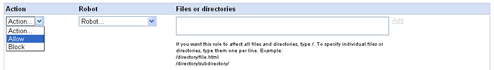

Gerar as regras do seu Robots.txt usando essa ferramente não tem segredo. O primeiro passo é selecionar a ação no combo box Action, você pode selecionar: “Allow” para habilitar páginas ou então “Block” para bloquea-las.

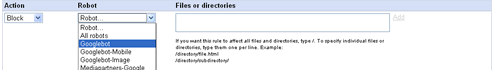

Após selecionar o tipo de regra, o proximo passo é selecionar para qual crawler ela vai ser aplicada, você pode escolher entre os que estão especificados no combo box ou então adicionar um crawler específico no contexto do seu robots.txt, selecionando a opção Other robot… neste box. Para inserir o novo crawler basta escrever o nome dele na caixa de texto que vai aparecer e escolher save.

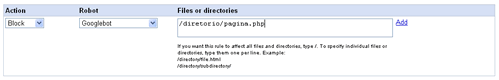

Uma vez selecionado o crawler, basta agora indicar a pasta sobre a qual a ação de bloqueio ou desbloqueio será efetuada, escrevendo o caminho na sessão Files or Directories. Escrito o caminho, pronto, basta clicar em Add e a regra será adicionada ao seu Robots.

Não existe limite para a quantidade de regras que pode ser adicionada, uma vez terminada uma regra para adicionar a próxima basta clicar em Add rule e recomeçar o processo.